Data

5

min de lectura

Qué es el Data Scraping y cuáles son sus aplicaciones para el Análisis de Datos

Don't you want to read? Try listening to the article in audio mode 🎧

Data Scraping es un tema particularmente amplio que afecta a varios contextos, desde la optimización de contenido para motores de búsqueda hasta el análisis de mercado, incluyendo estrategias comerciales y seguridad informática. Tratemos de entender en qué consiste este conjunto de técnicas y en qué áreas se puede usar para mejorar los datos.

En esencia, es una solución para el data mining que simplifica las operaciones de búsqueda en línea y es compatible con XPath, de esta manera los desarrolladores tienen la capacidad de crear scripts diseñados específicamente para interactuar con la información recopilada.

En esencia, es una solución para el data mining que simplifica las operaciones de búsqueda en línea y es compatible con XPath, de esta manera los desarrolladores tienen la capacidad de crear scripts diseñados específicamente para interactuar con la información recopilada.

Scraping: qué es

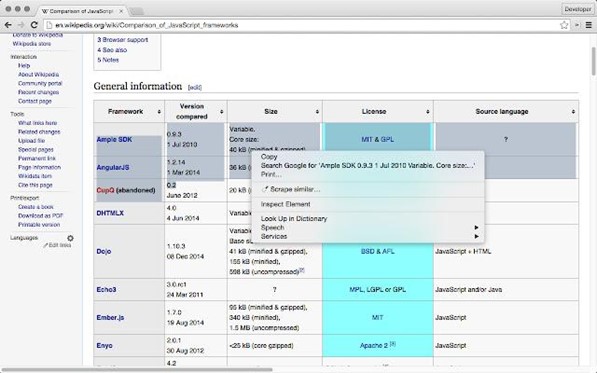

En su sentido más amplio, Data Scraping es un proceso a través del cual una aplicación extrae información del output generado por otro software. En el caso específico de una Web, Scraping consiste en tomar datos de las páginas de una web de Internet, clasificarlos según sus características, dividirlos en categorías y almacenarlos en una base de datos. Un ejemplo de Scraping podrían ser los motores de búsqueda. Plataformas como Google, de hecho, escanean constantemente la Web a través de un software llamado crawler (o spider) que opera automáticamente para identificar y analizar contenido. Las búsquedas de los usuarios se formulan a partir de cadenas de texto que contienen palabras clave y, dado que el objetivo de Google es dar respuestas lo más precisas posibles a estas consultas (o query), su crawler extrae textos o fragmentos de texto de sitios de Internet para tener información útil y datos con los que proponer resultados. Estos últimos se sugieren en la SERP (Search Engine Results Page) y se posicionan basándose en diversos criterios, como su relevancia, calidad desde el punto de vista de la experiencia del usuario y la autoridad de la fuente, con la que se potencian los datos obtenidos a través del Scraping.Uso ilícito del Scraping

Scraping no siempre es una actividad lícita. Por ejemplo, pensemos en el caso de las actividades de extracción de datos destinadas a la duplicación no autorizada de contenidos. En situaciones como estas, el resultado de estas técnicas puede llegar a violar los derechos de autor, especialmente cuando estos últimos no se mencionan y su trabajo se comparte total o parcialmente con ánimo de lucro. Scraping también puede estar en el centro de acciones maliciosas destinadas a robar datos útiles para campañas de phishing, robo de identidad y otros ataques cibernéticos. Por estas razones, en el pasado las redes sociales frecuentadas por gran parte de la población mundial como Facebook y LinkedIn habrían estado en el centro de las actividades de Scraping con el robo de datos pertenecientes a cientos de millones de usuarios. Para hacer el fenómeno aún más preocupante, está el hecho de que para llevar a cabo el Scraping de un sitio web no es necesario violar su base de datos, basta con escanear sus páginas disponibles al público. El software de Scraping tampoco se considera ilegal y puede ser utilizado para actividades de Análisis de Datos. Dicho esto, es bueno precisar que el RGPD, es decir, el reglamento general de protección de datos vigente en la Unión Europea, también considera como "tratamiento" únicamente el acceso a los datos personales, por lo que se deben utilizar las técnicas de Scraping teniendo en cuenta toda la normativa sobre protección de la intimidad.Scraping para análisis de datos

Scraping es por su naturaleza un proceso Data Driven, y las empresas lo utilizan para definir sus estrategias comerciales y de marketing. Pero, ¿cuáles son los sectores en los que sus técnicas son más rentables? Analicemos algunos de ellos.Análisis de texto y extracción de palabras clave

El éxito del contenido publicado en línea está determinado por varios factores, incluido el tráfico que pueden generar y la adherencia a las tendencias actuales. Desde este punto de vista, un análisis continuo de la oferta propuesta por otros creadores de contenido y competidores puede ser útil, sin embargo, dicho proceso puede ser todo un reto cuando se opera manualmente y por esta razón el Scraping es tan valioso. Un argumento muy similar puede usarse para las campañas de marketing digital, muchas veces en base a la mencionada creación de contenidos, para cuyo éxito es útil saber qué contenidos son recibidos de forma más favorable y cuáles son los más buscados por los usuarios, definiendo una tendencia. Por esta razón, para maximizar la competitividad, es fundamental hacer un trabajo que permita identificar las keywords de mayor impacto y, al mismo tiempo, encontrar otras nuevas con alto potencial de crecimiento. Por tanto, el Scraping se utiliza para extraer los textos o hashtags publicados en diferentes plataformas, agruparlos en categorías y someterlos a procesos de extracción de palabras clave, para identificar las que se incluirán en su contenido, así como en las campañas publicitarias.Análisis de precios

Otra área en la que Scraping se usa ampliamente para tomar decisiones comerciales es la fijación de precios. Sobre todo, las empresas que venden productos altamente competitivos necesitan saber si los precios cobrados son adecuados o si necesitan ser remodelados para garantizar el equilibrio adecuado entre el retorno y los parámetros del mercado. En este caso, se utiliza Scraping para identificar un dato preciso y el objetivo es crear una base de datos siempre actualizada con la que realizar análisis comparativos y a la que se pueda hacer referencia para la definición de estrategias de precios. Una actividad de este tipo también puede resultar especialmente útil para proponer descuentos, promociones y ofertas o en periodos en los que la propensión a comprar se hace más fuerte, como los del Black Friday, del Cyber Monday o de las compras navideñas en general.Algunas herramientas útiles para Scraping

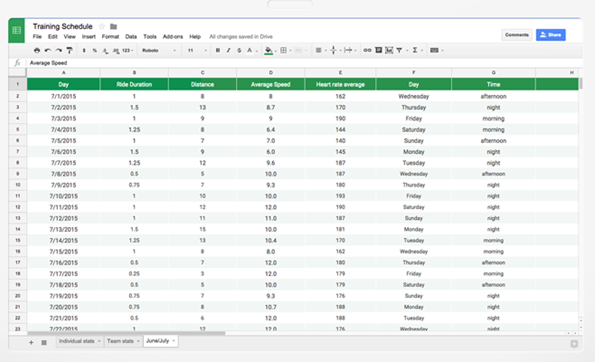

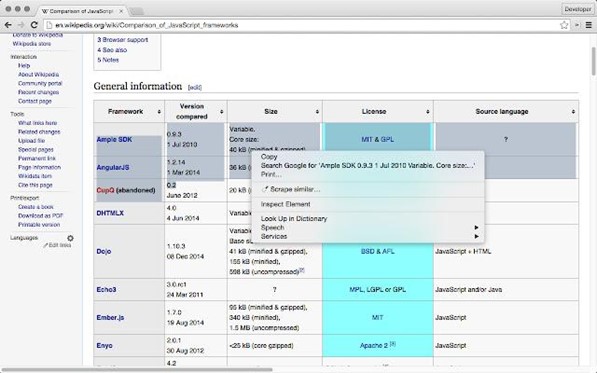

Gracias a la disponibilidad de algunas herramientas sin código, hoy el Scraping se ha convertido en un procedimiento más simple que no requiere conocimientos avanzados de programación. En la base de las tecnologías de Scraping existe de hecho un estándar llamado XPath, en la práctica un lenguaje que forma parte de la familia XML (eXtensible Markup Language) con el que es posible identificar, o más bien localizar, los nodos de un documento. Permite escribir expresiones con las que acceder directamente a elementos específicos de una página HTML, como una página Web, por lo que es ideal para extraer textos. Existen varias herramientas que te permiten realizar actividades de Scraping sin tener que escribir expresiones XPath o permitiéndote integrarlas cuando sea necesario, analicemos algunas de ellas.Google Sheets

Google Sheets es una herramienta hecha por Mountain View con la que crear y editar hojas de trabajo, en el caso de Scraping ofrece una de sus funciones más importantes a través de IMPORTXML.

fonte.(google.com)

Este último permite importar información de diferentes formatos para datos estructurados como XML, HTML, CSV, RSS y ATOM. Así al usar Google Sheet, es posible importar datos directamente desde sitios web y crear tablas listas para usar utilizando como fuente el contenido recopilado en línea.Scraper

Scraper es una extensión gratuita del navegador web Google Chrome que permite extraer partes específicas de una página de Internet. Los datos así recopilados pueden insertarse en una hoja de trabajo para actividades de análisis posteriores. En esencia, es una solución para el data mining que simplifica las operaciones de búsqueda en línea y es compatible con XPath, de esta manera los desarrolladores tienen la capacidad de crear scripts diseñados específicamente para interactuar con la información recopilada.

En esencia, es una solución para el data mining que simplifica las operaciones de búsqueda en línea y es compatible con XPath, de esta manera los desarrolladores tienen la capacidad de crear scripts diseñados específicamente para interactuar con la información recopilada.

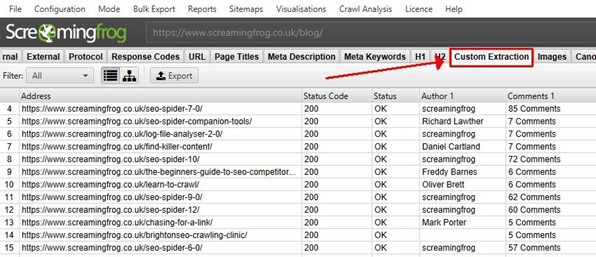

Screaming Frog

Screaming Frog es una herramienta especialmente indicada para actividades de Web Scraping orientadas al SEO (Search Engine Optimization). De hecho, la plataforma ofrece un SEO Spider Tool para extraer datos de sitios de Internet.fonte:(screamingfrog.co.uk)

La experiencia de usuario se puede personalizar mediante expresiones XPath, en su variante CSSPath que permite utilizar selectores CSS (Cascading Style Sheets) para localizar datos y utilizar expresiones regulares para definir patrones de búsqueda.Conclusiones

Scraping permite extraer datos de la salida de aplicaciones y páginas web a través de herramientas y procesos automatizados, su papel en el análisis de datos adquiere un papel cada vez más importante ya que permite acceder a información valiosa para marketing digital, SEO, estrategias de precios, procesos de negocios Data Driven y decisiones empresariales.

Artículo actualizado el: 09 agosto 2023

Escrito por

Talent Garden, Digital Skills Academy

No desperdicie su talento. Conviértalo en una carrera profesional con un curso que se adapte a sus necesidades.

Talent Garden es tu Digital Skills Academy, que ofrece cursos de Marketing Digital, Diseño UX, RRHH Digital y Análisis de Datos diseñados para lanzar tu carrera.

Seguir leyendo

4

min de lectura

¿Qué es el marketing de contenidos y cómo crear una estrategia eficaz?

Hoy en día, crear contenido atractivo y de calidad parece ser la única estrategia que puede garantizar la supervivencia ...

Talent Garden

19/05/2021

2

min de lectura

Youtube: la plataforma que ha cambiado el mundo

Cada minuto, se suben 400 horas de vídeo a YouTube. En 2016, una persona hubiera necesitado 1.700 años para ver todo el ...

Talent Garden

11/02/2021

5

min de lectura

¿Qué es el salario emocional? Cómo contentar al equipo tanto o más que con el dinero

“Un buen salario para el trabajador ya no es suficiente, ahora hay que buscar nuevas fórmulas para atraer a los mejores ...

Talent Garden

17/11/2022

3

min de lectura

La diferencia entre el modelo de datos conceptual y lógico

En una era, como la que vivimos, en la que hay una sobreabundancia de datos, un excelente diseño de base de datos es el ...

Talent Garden

17/09/2021